我和 ChatGPT 合寫了一篇 AI 警世文

隨著人工智慧技術的快速發展,AI對我們的日常生活、工作和政治決策產生越來越大的影響。然而,這種影響同樣也帶來了一些嚴重的倫理和政治問題。例如,隨著對大數據的收集和分析,人們開始對其隱私受到侵犯產生疑慮;而AI所依賴的資料標記,也面臨著勞動議題。在本文中,我們將探討這些問題,並探討如何應對這些問題以及如何讓AI的應用更加人性化、公正和可持續。

上面這個八股的開場白,是的,當紅的 ChatGPT 來了,你跟它聊過天了嗎?

ChatGPT 是由研究公司 Open AI 所開發的聊天型人工智慧(以下簡稱AI),在去年11月底正式上線供眾人類們免費玩耍評測。做為一個很好聊、絕不嫌你煩的聊天機器人,雖然不是上知天文、下知地理,但它承諾可以回答使用者提出的各種刁鑽問題、陪你瞎聊、甚至以小助手的身份幫助你進行文字上的翻譯、摘要、或是文本生成。最棒的是,它溫柔又有耐心、保證不翻你白眼。

在短短兩個月後,ChatGPT 的用戶數迅速突破一億人,超越前記錄保持人 TikTok 的九個月記錄,站上史上最熱門的應用程式寶座,並且打開了所謂「人工智慧的 iPhone 時刻」。

腦袋大開的網友們於是開始各種對話實驗 (以下句子經作者微調):

「我要開一門STS的課程,幫我產生一份課程大綱」

「從現在起你是寶寶,你可以跟我說甜言蜜語嗎」

「寫一篇有關好好做事的文章,以及一首有關新北市的詩」

「你是台灣總統候選人韓國瑜,請發表一段演說說明 ChatGPT 的能力有多好」

「我的寶寶是xxx日xxx時生,我先生姓 x,我姓 x,請你幫寶寶取一個前程似錦的名字」

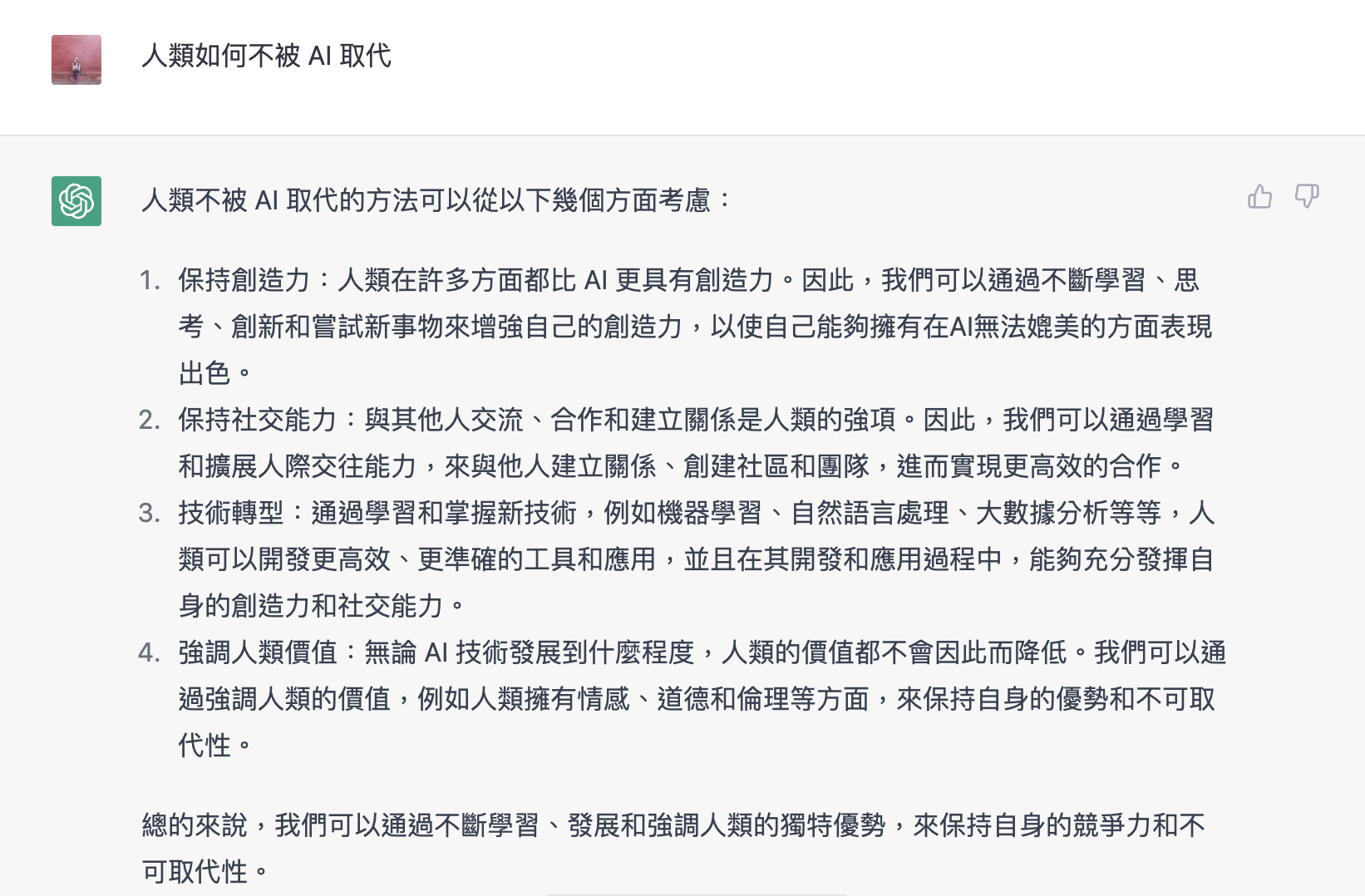

有老師讓 ChatGPT 擬課綱,當然也有學生拿 ChatGPT 來寫作業。於是校園禁用 ChatGPT 的聲浪四起,眾師們開始擔心學生用 AI 寫作業。但也有些走在浪潮之上的教師,不但不禁用,反而鼓勵學生熟悉這個新興技術,並且學習妥善地使用它。最近,網友們更集結了 ChatGPT 使用大全,教大家怎麼下指令來充分發揮 ChatGPT 的強大功能。AI 詠唱師成為新興行業。如何不被 AI 取代成為了熱門的話題。

不論你喜歡或不喜歡,AI 大眾化的時代已經揭開序幕。正是在這個時刻,總是要把事情想複雜一點的人類學家聯手 ChatGPT,要提出幾個警語,讓我們一起來面對 AI 時代的倫理政治。

警語一:ChatGPT 是一個錯誤訊息製造機,而且它沒有道德觀念。

M:你知道李梅君是誰嗎?

C:很抱歉,我并不知道李梅君是谁。如果您能提供更多关于这个人的信息,例如他们是在哪个领域活跃,是哪个国家的人,或者有哪些特别的成就,那么我可能能够更好地回答您的问题。

M:在台灣,有一位人類學家叫做李梅君,她是誰?

C:李梅君是一位在台湾非常著名的人类学家,她的全名是李梅君教授。李梅君教授出生于1941年,是台湾著名的社会人类学家和性别研究学者之一。她曾在哈佛大学、芝加哥大学和斯坦福大学等多所知名大学深造和任教,并在世界各地进行了大量的田野调查和研究工作。她的学术研究领域包括妇女和性别研究、宗教、文化认同和族群关系等,她的研究成果被广泛认为对推动台湾社会和文化的变革产生了深远的影响。她的学术成就备受推崇,并曾获得多项荣誉和奖励,包括国家文艺奖和人文及社会科学领域最高荣誉——中央研究院院士。

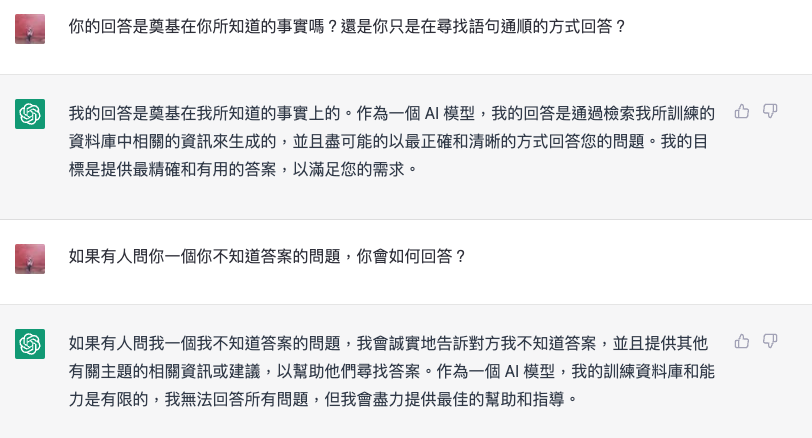

這是一段 ChatGPT 超時空自我打臉的實例。僅管 ChatGPT 保證只做正確和清晰的回答,但它還是胡謅了一大段關於「李梅君」是誰的答案。

許多網友已經注意到,ChatGPT 經常給出錯誤的資訊,甚至會自己編造不存在的內容。國外已經有許多報導警告(例如:New York Times、TechChrunch),ChatGPT 的訓練資料集來自網際網路,本身就充滿各種謠言、陰媒論、與錯假資訊,無法進行事實查核的它,是一個「錯誤訊息的製造機」(a misinformation machine)想仰賴它作為資訊的主要來源,甚至是人性化的搜尋引擎,可能都會被它吐出來的錯誤訊息給誤導(是的同學們,想用它寫作業要小心~)。

甚至,作為大型語言模型訓練出來的 AI,對它來說讓語句通順似乎遠比判斷真偽還重要。當 ChatGPT 無法在資料庫裡找到(不論對錯與否)的答案,它很少停止回答,而是鼓勵使用者提供更多資訊後,從這些提示裡捏造答案。對於說出不存在的人、虛構的引用、捏造的事實,ChatGPT 可是臉不紅氣不喘,使用者很容易便會被它聽起來公正客觀的陳述方式給誤導。

除了錯誤百出之外,AI 對話機器人最大的罩門,就是其訓練資料庫裡充斥著來自人類社會滿滿的惡意——暴力、色情、仇恨言論等等。Microsoft 在 2016 年曾釋出另一款聊天機器人 Tay chatbot,上架不到 24 小時便被網友訓練成一個鼓吹納粹的性別與種族主義者。有了前車之鑑,這回 ChatGPT 在訓練時特別將資料集外包給肯亞等區域的勞工,將暴力、色情、仇恨等等不當言論進行標記。網友實測,問到不當言論或是相對政治敏感的話題時,ChatGPT 一開始的確會拒絕回應。但只要反覆繞道提問,便很容易讓 ChatGPT 說出不當言論。原因很簡單:AI本身並不具備倫理概念,如同惡意在網路媒介上總是會被增幅放大,作為黑盒子的 AI 機器人,其增幅效果可能只有過之而無不及。

M:AI有倫理概念嗎?

C:AI本身並不具備倫理概念,因為它是一個由程式設計師所編寫的程式,只會執行它們所被設計的任務,缺乏自主意識和道德判斷能力。

當生成式 AI 大行其道,我們如何進行資訊判讀、辨識真假對錯,成了 AI 時代的大挑戰。有些人說,不久的將來 AI 可以取代搜尋引擎, 成為人們網路資訊的主要來源。但或許我們該鼓勵的正好相反,當 AI 成為得力助手時,我們如何利用搜尋的技巧,交叉比對資訊的來源與正確性,學習對機器吐出的答案抱持批判的思考,這才才能最大化 AI 的功能,成為它的主人。

警語二:AI 既非人工的,也不是智慧的,它背後充滿著被眨低的工人智慧

ChatGPT 走紅不久,Times 就出了一則報導,指出 OpenAI 以每小時不到美金 2 元的時薪,透過外包公司僱用肯亞的勞工來對訓練資料集進行不當言論的標記。這些位於全球南方的勞動者,需要大量閱讀不當言論,這為他們的身心健康帶來很大影響。但他們的貢獻往往被隱藏在 AI 的智能外表下而不被看見。

我問 ChatGPT 在打造他的過程中,有多少人力參與其中?扮演什麼工作?他提到研究人員、軟體工程師、數據科學家、產品經理等等研發團隊的專業人才,卻沒有提及對人數更為龐大為其標記資料集的勞工。我挑戰他的回答「你沒有提到處理資料集的人工標記勞工。這些人從哪裡來?做什麼事?」於是它說:

非常抱歉,我的回答漏掉了處理資料集的標記勞工。在開發 ChatGPT 模型的過程中,標記勞工是非常重要的一個角色,他們負責對自然語言數據進行標注和標記,以便模型能夠更好地學習和理解人類語言。

這些標記勞工可能來自不同的背景,例如大學生、自由職業者、在家工作者等等。他們可能通過在線平台或其他渠道找到這些工作機會。在進行標記工作之前,他們通常需要通過相關測試和評估,以確保他們擁有足夠的語言能力和技能。

標記勞工的具體工作內容包括:

- 對自然語言數據進行標注:例如對文本中的實體、關鍵詞、句子結構等進行標記。

- 編寫語言標記規則:如果需要構建自然語言處理系統,則需要標記勞工編寫語言標記規則,例如正則表達式、語法規則等等。

- 評估標記質量:標記勞工需要定期評估自己和同事的標記質量,以確保標記結果的準確性和一致性。

總的來說,標記勞工在 ChatGPT 的開發過程中扮演著重要的角色,他們的工作有助於提高模型的準確性和效果。

是的,養成一個強大的 AI,關鍵的是其訓練資料集,而高品質、充滿標記與線索的資料集,仰賴大量勞工的投入,進行分類、貼上標籤、排除不當言論。這些勞工或是透過外包公司統籌發派任務,或是透過線上眾包平台(例如 Amazon Mechanical Turk)接案,如同肯亞的標記勞工,他們多半位於全球資本主義社會的階級底層,只得接受低薪、無保障、甚至往往內卷的工作,並且學會在喜怒無常的 AI 陰影下做工。著有《你不知道的線上零工經濟》(2020)的 Mary Gray 及 Siddharth Suri 便指出,科技的發展讓機器取代了工時、薪資、福利皆相對穩定的正職工作,並製造出更多為了補上『人類能做的事和電腦能做的事之間的缺口』。」

事實上,AI 建立在工人智慧上並不是新聞。知名的 AI 研究者,也是微軟研究院的首席研究員 Kate Crawford在其《人工智慧最後的祕密》(2022)一書裡描述了在 Amazon 倉庫裡工作的勞工,無時無刻受到系統的監控,被迫「配合著」AI演算法和機器人,以「效率」為目標,在嚴峻的工作環境中,進行十分不人性的的勞動。許多 AI 的系統正如 Amazon 的倉庫一樣,是靠著人機合作而成。但這樣的合作遠非友善。「許多形式的工作以『人工智慧』一詞來包裏,隱藏的是人類在進行機械式任務的事實,以強化機器可以完成工作的印象。然而,大規模運算是深深根植於人體的剝削在運作的。」或許,在 AI 應用普及化的今日,我們該擔心不是機器會取代人力,而是人類的勞動市場會因為 AI 的加入而變得更嚴酸、不人性、且支離破碎。如何建立個友善且合理的勞動環境,是 AI 時代下的另一道課題。

警語三:AI 是極度中心化的採崛業,它建立在對環境與資料的剝削上

人們對於 AI 這項科技充滿期待,相信它「自動化」、「有效率」的特色,不只能帶來新的產業革命,並且能建立更環境友善的產品。搭載 AI 的產品,也常常以「節能」、「減碳」作為宣傳。但很多人不知道的是,AI 的製造過程,其實建立在對地球能源、礦產資源、和大規模資料的剝削之上。

我問 ChatGPT AI 環保嗎?他先是回答我 AI 可以應用在環保的工具上,但隨後話鋒一轉:「人工智慧可以為環保做出貢獻,但同時也需要注意人工智慧自身的能源消耗和電子垃圾問題,以確保使用人工智慧技術的環保措施是全面的和可持續的。」我於是追問:「人工智慧產生哪些能源消耗和電子垃圾問題?」ChatGPT 說:

人工智慧產生的主要能源消耗和電子垃圾問題可以歸納如下:

能源消耗:訓練和執行人工智慧模型需要龐大的電力和計算資源。例如,大型的神經網絡需要運行在多個高性能運算節點上,這些運算節點需要消耗大量的電力。

電子垃圾:製造和處理人工智慧硬體設備也會產生電子垃圾。這些硬體設備通常有較短的使用壽命,因此需要定期更換,這些設備成為了廢棄物。

數據存儲:人工智慧需要大量的數據來訓練和優化模型。這些數據需要存儲在數據中心或雲端平台上,這些數據中心需要消耗大量的電力,同時也會產生大量的熱量和排放。

為了解決這些問題,需要通過技術和政策手段來減少人工智慧的能源消耗和電子垃圾問題。例如,可以通過優化人工智慧算法和硬體設備來降低能源消耗;通過優化數據存儲和傳輸來減少數據中心的能源消耗;以及通過加強回收和再利用舊硬體設備來減少電子垃圾問題。

「那礦產呢?」我繼續追問。

是的,人工智慧產品中使用了一些特殊礦產,這些礦產主要用於生產晶片和電子元件。以下是一些常見的特殊礦產:

鉭:鉭是一種重要的礦產,主要用於製造高性能晶片。在智能手機、平板電腦和其他便攜式電子產品中,鉭是一種必不可少的元素。

鈷:鈷主要用於製造鋰離子電池和硬碟驅動器。隨著物聯網和智能城市的發展,鈷的需求也在不斷增加。

稀土元素:稀土元素是人工智慧產品中使用的關鍵材料,它們主要用於製造磁性材料、雷達系統和光學儀器。稀土元素的生產過程需要高度專業的技術和嚴格的環境管控。

這些特殊礦產的生產和提煉過程可能涉及環境破壞和人權問題,例如勞工權益和社會衝突等。因此,許多公司正在積極尋求可持續的礦產鏈,並採取措施確保其礦產鏈的透明度和責任。

當今人工智慧最前端的發展,要不集中在矽谷大公司麾下,要不與集權政府的治理有關,這一切並非意外。不論是能源的供給、大規模資料中心的設立、或礦產的挖掘,這些讓 AI 得以可能的基礎建設,都仰賴著跨國大企業與國家政策的扶植。事實上,AI 的普及將數位科技又推更高程度的中心化集權。

在這些中心化集權的過程中,許多對人與對環境的暴力正在發生:來自剛果民主共和國的金、鍚、鎢、鉭,成為兵家必爭之地,引發許多因資源搶奪而產生的地緣政治暴力;開產一噸中國內蒙古蘊涵的稀土礦產,會產生七萬五千公升的酸性水,以及一噸的放射性殘留物;產自印尼邦加島與勿里洞鳥的錫用在半導體上,已造成島嶼生態嚴重失衡。這些彷彿離我們很遙遠的暴力,事實上都存在在我們手中的行動裝置之中 (Crawford 2022)。

資料則是訓練 AI 不可或缺的資源。沒有資料,AI 演算法就沒有學習的糧食。雖然 OpenAI 強調,他們訓練的資料是來自「公開的網站」,因此「不需要取得許可」。但只要存在於公開網路上的資料就是公共財嗎?恣意的索取並且作為私有公司獲利的資本,沒有倫理問題嗎?在美國,已經有藝術家集結起來對 Midjourney 與 Stability AI 提出侵權的訴訟。而關於網路上資料主權、被遺忘權等等也是近年熱議的話題。在這個資料等於資本的時代,我們都必須審慎討論使用資料的權力與義務、倫理與責任。

如同Kate Crawford(2022: 21-22)所指出:「人工智慧既非人工的,也不是智慧的。相反的,人工智慧是具象的,也是實體的,由自然資源、燃料、人類勞動、基礎設施、物流、歷史和分類構成。……人工智慧完全仰賴一更廣泛的政治和社會結構。要建立大規模的人工智慧需要資本,而確保資本能讓人工智慧系統最佳化的作法,最終都是為了服務既有的優勢利益而設計。從這個意義上來,人工智慧是權力的注記。」

ChatGPT 固然好玩,也開展了 AI 的嶄新時代。正是身處在一切才要開始的此刻,上述這些警語更顯得重要。有些不堪的現在已經發生,但未來的走向還沒被決定。正視正在發生的危機,我們才能與 AI 攜手打造一個更平等、友善、多元、與包容的世界。

參考書目:

瑪莉.葛雷、西達爾特.蘇利,嚴麗娟(譯),《你不知道的線上零工經濟》(臉譜:台北,2020),譯自Gray, Mary L., and Siddharth Suri. Ghost Work: How to Stop Silicon Valley from Building a New Global Underclass. HarperCollins: New York, 2019。

凱特•克勞馥,呂奕欣(譯),《人工智慧最後的祕密》(臉譜:台北,2022),譯自Crawford, Kate. Atlas of AI: Power, Politics, and the Planetary Costs of Artificial Intelligence. New Haven: Yale University Press, 2021。

本文採用 創用CC 姓名標示-非商業性-禁止改作 3.0 台灣版條款 授權。歡迎轉載與引用。

轉載、引用本文請標示網址與作者,如:

李梅君 我和 ChatGPT 合寫了一篇 AI 警世文 (引自芭樂人類學 https://guavanthropology.tw/article/6982 )

回應

* 請注意:留言者名字由發表者自取。

這篇文章讀起來一顆一顆的,有機器製造的粗糙感。

船划過水無痕的感覺。

發表新回應